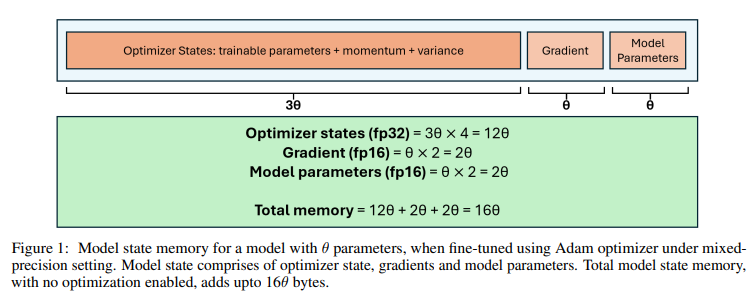

1. Introduction전이 학습이란, 이미 학습된 모델을 다른 작업에 활용하는 것을 말한다. 그 예시중엔 fine tuning이 있다. 그런데, fine tuning을 하려면, 10억(1B)개의 파라미터를 가진 LLM을 full fine-tuning(32bit 부동소수점)하려면, 24GB의 메모리가 필요하다. 따라서, 메모리 최적화 없이 LLM을 파인튜닝하면 OOM(Out of Memory)에러가 맨날 뜨는 것을 볼 수 있다. 이 논문에서는 LLM 파인튜닝을 위한 대표적인 최적화 기법들에 대해 자세히 소개하고, 메모리 사용량과 실행 시간 사이의 절충 관계를(trade-off) 분석하며, 실험 결과를 통해 최적의 조합을 선택하기 위한 가이드라인과 기준점을 제시한다. 2. Related Work1...